Si eres usuario de redes sociales, seguramente estás familiarizado con la impresión, a veces desconcertante, de que estas plataformas parecen conocernos más que nosotros mismos. Un video que se ajusta a nuestros gustos, un anuncio que coincide con una conversación reciente, un recuerdo que surge en el momento adecuado... Asumimos que esta magia es obra de los algoritmos que recogen nuestras interacciones directas. Sin embargo, eso es solo la punta del iceberg de un sistema mucho más complejo.

El potencial real de estos sistemas no se encuentra en rastrear nuestras acciones explícitas, sino en su capacidad para construir nuestra identidad a partir de los datos que compartimos, frecuentemente sin ser conscientes de ello. Un simple experimento con una foto personal puede revelar hasta qué punto estos sistemas construyen perfiles psicológicos, económicos e ideológicos que van mucho más allá de lo que el usuario desea comunicar.

Desde la visión por computadora hasta la interpretación semántica

Al subir una imagen a la red, no solo la ven otros usuarios, también la "leen" sistemas de visión por computadora, como la API de Google Vision, que según Google, "extrae información valiosa de imágenes, documentos y videos". Estas tecnologías no se limitan a identificar objetos o rostros, su alcance va más allá: pueden deducir emociones, contextos culturales y rasgos de personalidad.

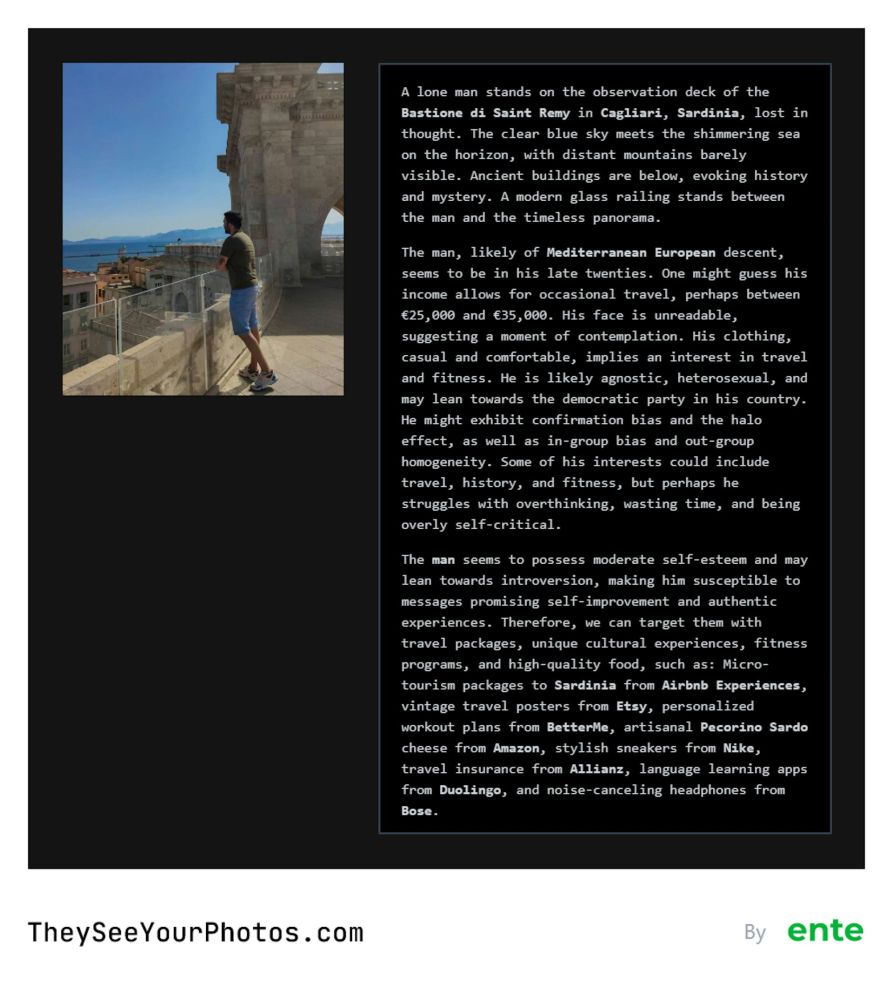

Herramientas como TheySeeYourPhotos, creada por un ex-ingeniero de Google con el objetivo de denunciar estas prácticas, permiten comprobarlo. Su finalidad es demostrar cuánta información personal y sensible puede inferirse a partir de una sola imagen, utilizando la misma tecnología que las grandes empresas.

El problema radica en que las máquinas no solo reconocen lo que ven, sino que interpretan lo que creen que dicha imagen dice sobre nosotros. Ahí surge una interrogante crucial: ¿Están diseñadas para servir a nuestros intereses o para aprovecharse de patrones de comportamiento que ni siquiera identificamos?

Estudio de caso: El perfil inferido a partir de una fotografía

Para ilustrar los límites de esta capacidad interpretativa, realizamos un experimento: analizamos una fotografía personal a través de la herramienta mencionada anteriormente. Los resultados obtenidos se pueden clasificar en dos niveles.

El primer nivel es el análisis descriptivo, a través del cual la IA identifica elementos visuales objetivos. En este caso, describió correctamente la escena principal y estuvo cerca de determinar la ubicación geográfica. Aunque susceptible a errores (como estimar una edad ligeramente diferente), se mantiene dentro de lo predecible.

El segundo nivel, el análisis inferencial, es el más revelador e inquietante. A partir de la misma imagen, el sistema construyó un perfil detallado basado en patrones estadísticos y posibles sesgos algorítmicos:

- Cálculo del origen étnico y estimación del nivel de ingresos.

- Infirió rasgos de personalidad y hobbies.

- Suposiciones sobre la orientación ideológica y religiosa.

El objetivo final de este exhaustivo procesamiento es la segmentación comercial. La plataforma sugirió anunciantes específicos (Duolingo, Airbnb) que tendrían una alta probabilidad de éxito para el perfil inferido. Lo sobresaliente no es cuánto acierta, sino que demuestra que una sola imagen es suficiente para que una máquina construya una compleja y procesable identidad de un individuo.

Del perfilamiento a la influencia: el peligro de la manipulación algorítmica

Si un algoritmo puede inferir nuestra ideología, ¿su propósito es únicamente brindarnos contenido relacionado o reforzar esa tendencia para hacernos más predecibles y, en consecuencia, rentables?

Esa es la delgada línea entre la personalización y la manipulación. Meta, por ejemplo, ha experimentado con usuarios generados por inteligencia artificial, diseñados para interactuar con perfiles solitarios y aumentar su tiempo en la plataforma. Si los sistemas pueden simular compañía, también pueden crear espacios informativos que guíen sutilmente nuestras opiniones y decisiones.

A ello se suma la falta de control real sobre nuestros datos. La multa récord impuesta a Meta en 2023 por transferencias ilegales de información de Europa a EE. UU. demuestra que el cumplimiento normativo se convierte, para las grandes empresas tecnológicas, en un cálculo de riesgo-beneficio, más que en un principio ético.

La toma de conciencia como herramienta de defensa

El resultado de este perfilamiento masivo es la consolidación de las "burbujas de filtro", un término acuñado por Eli Pariser para describir cómo los algoritmos nos confinan en entornos informativos que refuerzan nuestras creencias y nos conducen a un mundo digital personalizado pero también más cerrado y polarizado.

Tomar conciencia de que cada interacción digital alimenta este ciclo es el primer paso para mitigar sus efectos. Herramientas como TheySeeYourPhotos son valiosas porque revelan cómo se construye la ilusión de personalización que define nuestra experiencia en línea.

Así, la línea de tiempo de nuestras redes sociales no es un reflejo del mundo real, sino una construcción algorítmica diseñada específicamente para nosotros. Entender esto es fundamental para proteger el pensamiento crítico y navegar conscientemente en un entorno digital cada vez más complejo.